AI电子宠物情感伴侣的技术实现与架构解析

快速体验

在开始今天关于 AI电子宠物情感伴侣的技术实现与架构解析 的探讨之前,我想先分享一个最近让我觉得很有意思的全栈技术挑战。

我们常说 AI 是未来,但作为开发者,如何将大模型(LLM)真正落地为一个低延迟、可交互的实时系统,而不仅仅是调个 API?

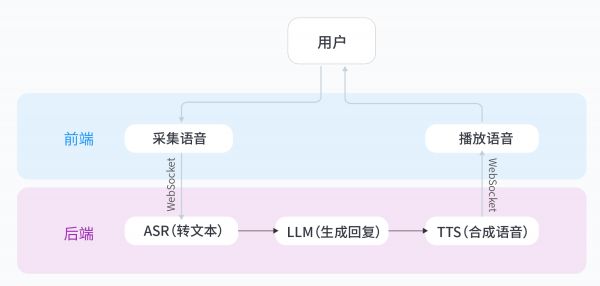

这里有一个非常硬核的动手实验:基于火山引擎豆包大模型,从零搭建一个实时语音通话应用。它不是简单的问答,而是需要你亲手打通 ASR(语音识别)→ LLM(大脑思考)→ TTS(语音合成)的完整 WebSocket 链路。对于想要掌握 AI 原生应用架构的同学来说,这是个绝佳的练手项目。

从0到1构建生产级别应用,脱离Demo,点击打开 从0打造个人豆包实时通话AI动手实验

AI电子宠物情感伴侣的技术实现与架构解析

传统虚拟宠物的情感交互困境

早期的电子宠物游戏如拓麻歌子,主要通过预设的状态机和简单规则来模拟生物行为。这种设计存在三个明显缺陷:

交互模式固化:对话选项局限于固定套路,无法理解用户真实意图情感反馈单一:快乐/悲伤等状态仅通过数值变化体现,缺乏细腻表达记忆能力缺失:每次交互都是独立事件,无法形成持续的情感纽带现代情感计算技术栈对比

当前实现情感交互主要有三种技术路线:

规则引擎

优点:开发速度快,行为可控

缺点:需人工编写大量对话树,难以覆盖复杂场景

传统机器学习

使用SVM/随机森林处理情感分类

优点:训练成本低

缺点:特征工程依赖领域知识

深度学习方法

典型方案:BERT+LSTM+Attention

优点:端到端学习,可捕捉细微情感差异

缺点:需要大量标注数据

核心模块实现详解

情感识别引擎采用多模态输入处理架构:

from transformers import BertTokenizer, BertForSequenceClassification

tokenizer = BertTokenizer.from_pretrained('bert-base-chinese')

model = BertForSequenceClassification.from_pretrained('bert-base-chinese', num_labels=6)

def analyze_emotion(text):

inputs = tokenizer(text, return_tensors="pt", padding=True)

outputs = model(**inputs)

return torch.softmax(outputs.logits, dim=1)

python

运行

动态响应生成结合LSTM和情感词典的混合方案:

class ResponseGenerator(nn.Module):

def __init__(self, vocab_size, embedding_dim, hidden_dim):

super().__init__()

self.embedding = nn.Embedding(vocab_size, embedding_dim)

self.lstm = nn.LSTM(embedding_dim, hidden_dim)

self.attention = nn.MultiheadAttention(hidden_dim, num_heads=4)

def forward(self, input_seq, emotion_vec):

embedded = self.embedding(input_seq)

lstm_out, _ = self.lstm(embedded)

attn_out, _ = self.attention(lstm_out, emotion_vec, emotion_vec)

return attn_out

python

运行

长期记忆系统采用图数据库存储交互历史:

from neo4j import GraphDatabase

class MemorySystem:

def __init__(self):

self.driver = GraphDatabase.driver("bolt://localhost:7687")

def record_interaction(self, user_id, emotion, dialog):

with self.driver.session() as session:

session.write_transaction(

self._create_interaction,

user_id,

emotion,

dialog

)

@staticmethod

def _create_interaction(tx, user_id, emotion, dialog):

tx.run("""

MERGE (u:User {id: $user_id})

CREATE (u)-[:HAS_EMOTION]->(e:Emotion {type: $emotion})

CREATE (e)-[:IN_CONTEXT]->(d:Dialog {text: $dialog})

""", user_id=user_id, emotion=emotion, dialog=dialog)

python

运行

性能优化关键策略

模型推理加速动态量化:将FP32模型转为INT8

quantized_model = torch.quantization.quantize_dynamic(

model, {nn.Linear}, dtype=torch.qint8

)

python

运行

模型蒸馏:用大模型训练小模型

distiller = Distiller(

teacher_model=large_model,

student_model=small_model,

temperature=2.0

)

distiller.train(teacher_logits, student_logits)

python

运行

内存管理技巧 使用内存映射文件加载大模型实现对话状态的LRU缓存启用CUDA图形加速推理隐私保护方案

采用联邦学习架构保护用户数据:

from syft import VirtualWorker, hook

hook = sy.TorchHook(torch)

bob = VirtualWorker(hook, id="bob")

encrypted_emotion = emotion_data.fix_precision().share(bob, alice)

python

运行

部署常见问题解决

冷启动问题

解决方案:预加载基础情感模板

长对话崩溃

解决方案:实现对话分块处理

多用户并发

解决方案:采用异步IO架构

伦理边界思考

当AI能够精准识别和响应人类情感时:

如何防止情感操控?该不该设置情感交互红线?用户是否拥有"数字遗忘权"?想亲手构建这样的AI伴侣?可以参考这个从0打造个人豆包实时通话AI实验,用完整的技术栈实现实时语音交互。我在实践中发现其ASR-TTS链路延迟控制得非常出色,适合作为情感交互的基础框架。

实验介绍

这里有一个非常硬核的动手实验:基于火山引擎豆包大模型,从零搭建一个实时语音通话应用。它不是简单的问答,而是需要你亲手打通 ASR(语音识别)→ LLM(大脑思考)→ TTS(语音合成)的完整 WebSocket 链路。对于想要掌握 AI 原生应用架构的同学来说,这是个绝佳的练手项目。

你将收获:

架构理解:掌握实时语音应用的完整技术链路(ASR→LLM→TTS)技能提升:学会申请、配置与调用火山引擎AI服务定制能力:通过代码修改自定义角色性格与音色,实现“从使用到创造”

从0到1构建生产级别应用,脱离Demo,点击打开 从0打造个人豆包实时通话AI动手实验

相关知识

宠物机器人的未来:用AI技术打造情感伴侣与智能助手

站在风口上的AI电子宠物玩具——开启智能陪伴的新纪元

AI电子宠物Moflin:未来宠物陪伴的风向标?

宠智灵AI结构化处理宠物理赔材料解决方案:RAG架构驱动的行业变革

人工智能养宠攻略:教你打造会听会说的“电子伴侣”

人工智能养宠攻略:教你打造会听会说的‘电子伴侣’

深度解析:AI宠物技术革新引领情感交互新趋势

电子宠物爆发:AI机器人能否陪伴我们慢慢变老?**情感计算**与**陪伴机器人**的未来

宠智灵宠物AI识别能力API接口服务:RAG架构驱动的行业变革

AI与宠物关怀:从情感识别到智能问诊的创新

网址: AI电子宠物情感伴侣的技术实现与架构解析 https://www.mcbbbk.com/newsview1340876.html

| 上一篇: 安防企业跨界AI宠物?观望痛点与 |

下一篇: 前后端分离宠物领养系统系统|Sp |

推荐分享

- 1养玉米蛇的危害 28694

- 2狗交配为什么会锁住?从狗狗生 7180

- 3我的狗老公李淑敏33——如何 6236

- 4豆柴犬为什么不建议养?可爱的 4637

- 5南京宠物粮食薄荷饼宠物食品包 4563

- 6中国境内禁养的十大鸟种,你知 4429

- 7湖南隆飞尔动物药业有限公司宠 4259

- 8自制狗狗辅食:棉花面纱犬的美 4257

- 9家养水獭多少钱一只正常 4212

- 10广州哪里卖宠物猫狗的选择性多 4122